おすすめ - sirius

2023/11/29 (Wed) 04:54:46

6872 日本マイクロニクス

6872 日本マイクロニクス

明日上がるかどうかわかりませんが、下げてきたら買いと思います。

次の半導体相場は、「メモリー」それも『HBM』関連だと思います。

日本には、HBMを造っている上場会社はありませんが、

関連会社だと日本マイクロニクスだと思います。

四半期前の決算の書き起こしです。

質疑応答が興味深いです。

https://finance.logmi.jp/378371

この後、7〜9月の決算で、四半期の受注過去最高となっています。

要因は

①一般のメモリー;DRAMも4〜6で底打ち。

②底打ち後のこの時期にメモリー向けの受注四半期で過去最高となるのは、HBM向けのプローブカードが絶好調だからです。

2位以下(日本電子材料など)は、HBM向けのプローブカードにそれほどシェア大きくない様です。

③HBM向けプローブカードは、価格も利益率も従来のメモリー向けプローブカードよりも高い様なので、増額修正となりました。

会社側は、1〜3月以降HBM向けが大幅に増えると想定している様です。

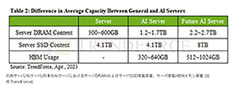

TrendForceでは、AIサーバの台頭により、メモリの容量に対する需要が高まる可能性も指摘している。一般的なサーバではサーバDRAMが500~600GBほど搭載されるが、AIサーバでは、平均で1.2~1.7TBのメモリ容量が必要とされる。エンタープライズSSDの場合、AIサーバの高速性が要求されるため、DRAMまたはHBMが優先されるが、SSDのメモリ容量を拡大するという目立った動きはまだ見られないとTrendForceでは分析する一方、インタフェースに関しては、高速コンピューティングのニーズに対応する場合、PCIe 5.0の方が有利であるとする。さらに、AIサーバにGPUが搭載される傾向から、NVIDIA A100 80GBが4つもしくは8つ用いる構成の場合、HBMの合計容量は約320GB~640GBとなるが、AIのモデルがますます複雑になるにつれて、サーバDRAM、SSD、およびHBMの需要も増加していくこととなり、半導体の消費量増加に寄与することが予想されるとしている。

TrendForceによると、2022年の高帯域幅メモリ(HBM)サプライヤ別シェアはSK hynixが50%、Samsung Electronicsが40%、Micron Technologyが10%となったという。

ディープラーニング用に設計されたハイエンドGPUを搭載するAIサーバサプライヤからの需要が伸びているほか、2023年下半期にNVIDIA H100およびAMD MI300の市場投入が予定されており、主要サプライヤ3社ともにHBM2と比べ、ピン当たりのデータレートが2倍に相当する6.4Gbps、デバイス当たり819GBpsを実現する次世代規格品であるHBM3の大量生産を進めることが予想されるという。

中でもSK hynixはすでにHBM3の大量生産を他社に先駆けて開始していることから、その市場シェアは2023年に53%まで拡大するとTrendForceでは予想している。残るSamsungとMicronは、2023年末から2022年初頭での大量生産開始を予定しており、2023年のHBM市場シェアはそれぞれ38%、9%に留まるとも予想している。

Re: おすすめ - sirius

2023/11/29 (Wed) 05:06:26

ビーイングホールディングス

ご参考まで

https://youtu.be/nFLrx56w7fg?si=o5UvVlquz2xwZJ_e

Re: おすすめ - sirius

2023/11/29 (Wed) 16:16:47

NVDAのサーバーH100の場合、1つのシステムにのGPUの入った基盤が8つ、で構成されています。

今のところ、各GPUにそれぞれ6つのHBM3(16G〜32G)が掲載されているので、合計48個のHBM が必要になります。